8个DeepSeek-R1私有化部署方案

本文了解如何在本地和没有互联网的情况下运行DeepSeek R1推理模型,或者通过可信赖的托管服务来运行它。

关于LangChat

LangChat 是Java生态下企业级AIGC项目解决方案,集成RBAC和AIGC大模型能力,帮助企业快速定制AI知识库、企业AI机器人。

支持的AI大模型: Gitee AI / 阿里通义 / 百度千帆 / DeepSeek / 抖音豆包 / 智谱清言 / 零一万物 / 讯飞星火 / OpenAI / Gemini / Ollama / Azure / Claude 等大模型。

- 官网地址:http://langchat.cn/

开源地址:

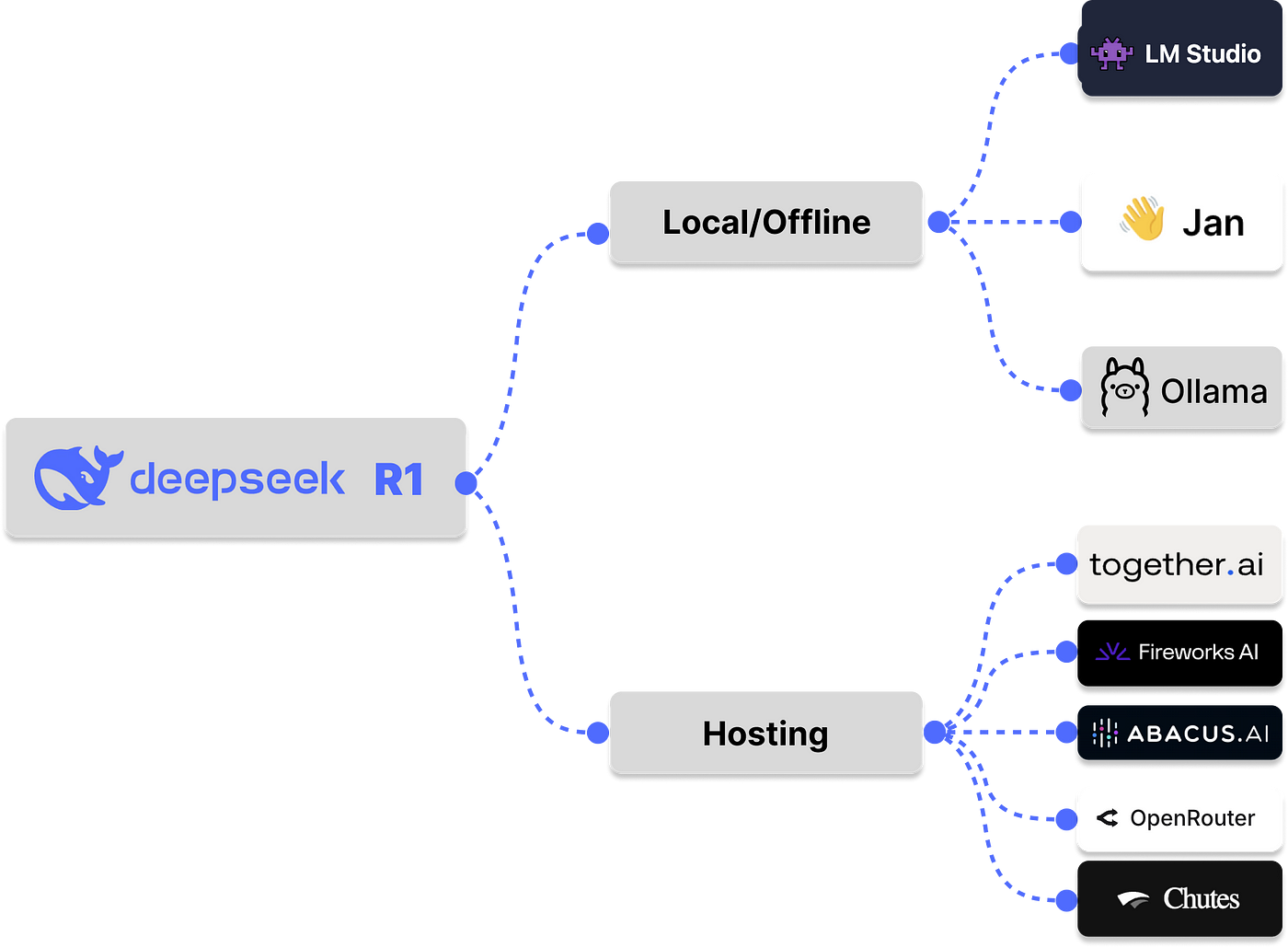

运行DeepSeek R1 fffline并托管

许多人(尤其是开发人员)想使用新的DeepSeek R1思维模型,但担心将其数据发送到DeepSeek 。阅读本文,以了解如何在本地和不使用Internet或使用受信任的托管服务的情况下使用和运行DeepSeek R1推理模型。您将模型脱机运行,因此您的私人数据与您一起停留,并且不会将计算机留给任何LLM托管提供商(DeepSeek)。同样,借助值得信赖的托管服务,您的数据将转到第三方托管提供商而不是DeepSeek。

使用LMSTUDIO,OLLAMA和JAN在本地/离线运行DeepSeek R1或通过LLM服务平台,例如Groq,Fireworks AI以及AI共同有助于消除数据共享和隐私问题。

什么是DeepSeek R1?

DeepSeek聊天UI

OpenAI O1和最新模型(例如OpenAI O3和DeepSeek R1)解决了数学,编码,科学和其他领域的复杂问题。这些模型可以考虑从用户查询的输入提示,并在生成最终解决方案之前仔细研究推理步骤或思想链(COT)。在撰写本文时,以上三种语言模型是具有思维能力的模型。 DeepSeek R1模型由基本R1模型和六个蒸馏版组成。蒸馏型从较小的版本到较大的版本,这些版本用Qwen和Llama进行了微调。

人们为什么要使用R1但存在隐私问题?

R1模型无疑是世界上最好的推理模型之一。它的功能引起了开发人员社区对X , Reddit , LinkedIn和其他社交媒体平台的关注和关注。但是,使用DeepSeek提供的语言模型有一些错误的信息和错误的方法。例如,有些人认为DeepSeek是一个附带项目,而不是公司。其他人认为DeepSeek可能会将用户的数据用于其他目的,而不是其隐私政策中所述的内容。像OpenAI一样, DeepSeek聊天的托管版本可能会收集用户的数据,并将其用于培训和改进其模型。话虽如此,这并不意味着您不应该相信使用托管的DeepSeek聊天。它与Chatgpt类似,是使用DeepSeek R1模型测试和生成响应的绝佳工具。有些人和公司不希望DeepSeek由于隐私问题而收集数据。此外,DeepSeek总部位于中国,有几个人担心与中国的一家公司共享其私人信息。

一个人如何在不与DeepSeek共享信息的情况下下载,安装和运行DeepSeek R1的思维模型家族?继续阅读以探索您和您的团队如何在没有互联网的情况下在本地运行DeepSeek R1模型,或者使用欧盟和美国基于美国的托管服务。

为什么要DeepSeek R1?

R1模型背后的公司DeepSeek最近进入了主流大语言模型(LLM )提供商,加入Openai , Google , Anthropic , Meta AI , Groqinc , Mistral等主要参与者。 DeepSeek R1型号是开源的,成本低于OpenAI O1型号。成为开源为机器学习和开发人员社区提供了长期利益。人们可以为不同用例复制R1模型的版本。尽管成本较低,但它仍与OpenAI O1型号相当。它令人难以置信的推理功能使其成为OpenAI O1型号的绝佳选择。凭借其有趣的推理能力和低成本,许多人(包括开发人员)想使用它来为其AI应用程序供电,但担心将其数据发送到DeepSeek。的确,将DeepSeek R1模型与DeepSeek聊天这样的平台使用,您的数据将由DeepSeek收集。但是,您可以在计算机上完全离线运行DeepSeek R1模型,也可以使用托管服务来运行该模型来构建您的AI应用程序。

像其他大型语言模型(LLMs ),您可以使用本地运行并测试原始的DeepSeek R1型号和机器上的DeepSeek R1家族LLM托管工具。使用R1型号的一个好处是,它们可以在诸如Groq,foring.ai等托管平台上使用。通过这些平台使用这些模型是通过DeepSeek聊天和API直接使用它们的理想选择。微软最近制作了R1型号,并在其Azure AI Foundry和Github上提供了蒸馏版。

什么是当地的第一LLM工具?

使用时LLMs像Chatgpt或Claude一样,您也使用OpenAI和Anthropic托管的模型,因此这些提供商可能会收集您的提示和数据来培训和增强其模型的功能。如果您担心将数据发送到这些LLM提供者,您可以使用本地优先LLM工具以离线运行您的首选模型。当地第一LLM工具是一种工具,可让您在不使用网络的情况下聊天和测试模型。使用Lmstudio,Ollama和Jan等工具,您可以与您喜欢的任何型号进行聊天,例如DeepSeek R1型号100%离线。了解有关本地第一的更多信息LLM我们最近的文章和YouTube教程之一中的工具。

必备当地人LLMDeepSeek R1的工具

与Lmstudio,Jan和Ollama在本地运行DeepSeek R1

自从DeepSeek R1模型发布以来,本地数量越来越多LLM下载和使用模型的平台而无需连接到Internet。以下是在撰写本文时可以使用R1脱机的三个最佳应用程序。我们将偶尔更新文章作为本地数量LLM工具支持R1增加。

LMStudio

使用LMSTUDIO在本地运行DeepSeek R1

LMstudio提供了可以离线运行的DeepSeek R1的蒸馏版。首先,下载lmstudio,启动它,然后单击左面板上的**“发现”选项卡以下载,安装和运行任何蒸馏版R1。在YouTube上使用LMSTUDIO在本地观看Run Run Run DeepSeek R1,**以便逐步快速指南。

奥拉马

下载Ollama

使用Ollama,您可以在没有网络的情况下使用单个命令运行DeepSeek R1型号100%。首先,安装Ollama ,然后运行以下命令来拉动并运行DeepSeek R1模型:

ollama run deepseek-r1您还可以拉动并运行DeepSeek R1型号的以下蒸馏Qwen和Llama版本。

QWEN蒸馏DeepSeekr1型号

- DeepSeek-R1-Distill-Qwen-1.5b :

ollama run deepseek-r1:1.5b - DeepSeek-R1-Distill-Qwen-7b :

ollama run deepseek-r1:7b - DeepSeek-R1-Distill-Qwen-14b :

ollama run deepseek-r1:14b - DeepSeek-R1-Distill-Qwen-32b :

ollama run deepseek-r1:32b

美洲驼蒸馏DeepSeekr1模型

- DeepSeek-R1-Distill-Lalama-8B :

ollama run deepseek-r1:8b - DeepSeek-R1-Distill-Lalama-70b :

ollama run deepseek-r1:70b

下面的预览展示了如何与Ollama一起运行DeepSeek-R1-Distill-Lalama-8b 。

Ollama运行DeepSeek-R1

观看Run DeepSeek R1 + Ollama本地LLM在YouTube上的工具进行快速演练。

Jan:与DeepSeek R1离线聊天

与Jan下载DeepSeek R1

Jan将自己描述为一种开源Chatgpt替代方案。这是当地的第一LLM运行DeepSeek R1型号100%离线的工具。使用JAN运行DeepSeek R1仅需要下图中所示的三个步骤。

与Jan一起运行DeepSeek R1的步骤

下载Jan ,然后前往左图上的Hub选项卡,以搜索并下载从拥抱面中的任何蒸馏R1 GGUF型号。

DeepSeek R1 Qwen蒸馏型

- 1.5b: https ://huggingface.co/bartowski/deepseek-r1-distill-qwen-1.5b-gguf

- 7b: https ://hugingface.co/bartowski/deepseek-r1-distill-qwen-7b-gguf

- 14b: https ://huggingface.co/bartowski/deepseek-r1-distill-qwen-14b-gguf

- 32B: https ://hugingface.co/bartowski/deepseek-r1-distill-qwen-32b-gguf

DeepSeek R1美洲驼蒸馏模型

- 8b: https ://huggingface.co/unsloth/deepseek-r1-distill-llama-8b-gguf

- 70B: https ://hugingface.co/unsloth/deepseek-r1-distill-lma-70b-gguf

一旦您下载了带有JAN的任何蒸馏R1型号,就可以按照以下预览进行运行。

与Jan一起运行DeepSeek R1

其他替代方案:使用企业准备就绪LLM托管R1托管

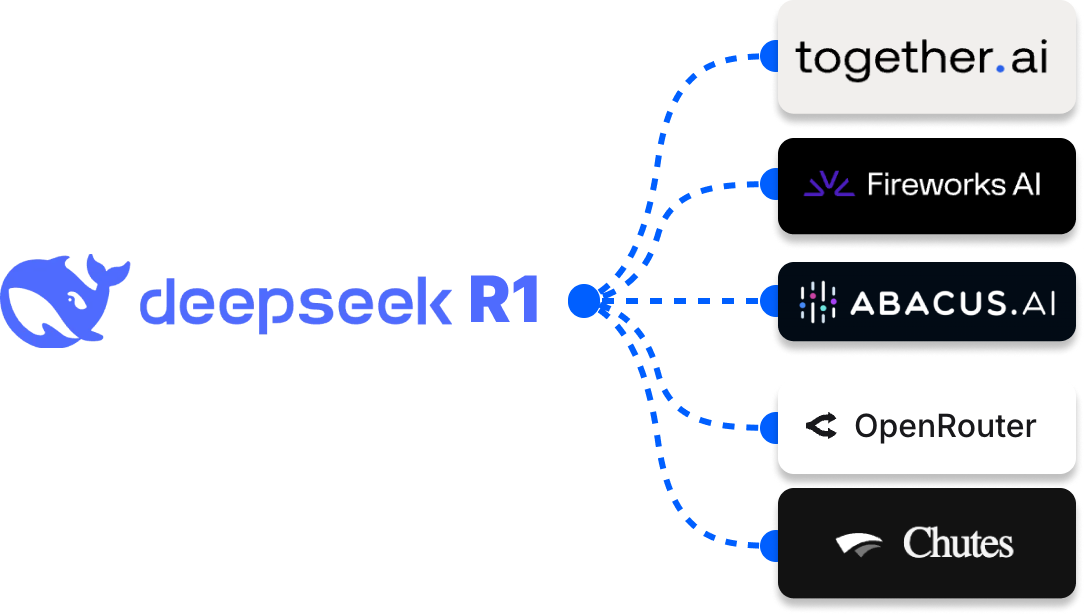

DeepSeek R1托管选项

尽管最近发布了DeepSeek R1模型,但有些值得信赖LLM托管平台支持它。如果您不想使用上面概述的离线方法,则可以从以下任何提供商访问模型。可能有几个LLM在此处陈述的托管平台中缺少平台。但是,以下是领先的平台,您可以在其中访问DeepSeek R1型号及其蒸馏器。

格罗克

在Groq上运行DeepSeek R1

GROQ支持DeepSeek-R1-Distill-Llama-70B版本。要使用它,请访问https://groq.com/并直接在主页上运行模型。 另外,您可以通过单击主页右上角的DEV控制台按钮在Groq上运行R1模型,如下图所示。

使用Groq Dev Console运行DeepSeek R1

Azure AI铸造厂

访问Azure AI Foundry的DeepSeek R1

如上图所示,您可以在Microsoft的Aure AI Foundry上访问DeepSeek R1的蒸馏版。访问Azure AI Foundry网站以开始。

其他受欢迎LLM托管平台您可以运行DeepSeek R1的蒸馏型号包括以下链接。

deepseek r1一起。

- https://fireworks.ai/

- https://www.together.ai/

- https://openrouter.ai/

- https://chatllm.abacus.ai/

- https://chutes.ai/

DeepSeek R1和开源模型的未来

在本文中,您学会了如何使用本地优先权运行DeepSeek R1模型LLMLmstudio,Ollama和Jan等工具。您还学会了如何使用可伸缩和企业准备LLM托管平台运行模型。 DeepSeek R1模型是OpenAI O1模型的绝佳替代方法,能够推理完成高度要求和合乎逻辑的任务。

在撰写本文时,可访问DeepSeek R1模型LLM托管平台,例如Azure AI Foundry和Groq 。这些平台确保其托管语言模型的可靠性和安全性。将来,我们希望看到更多的公司和开源开发人员重现DeepSeek R1模型,并为不同的用例提供。另外,许多本地第一LLM工具和托管服务可以支持DeepSeek R1型号及其蒸馏版。

联系我

最后,推荐大家关注一下开源项目:LangChat,Java生态下的AIGC大模型产品解决方案。

- LangChat产品官网:https://langchat.cn/

- Github: https://github.com/TyCoding/langchat

- Gitee: https://gitee.com/langchat/langchat

- 微信:LangchainChat